“危險!立刻停下所有大型AI研究!”馬斯克領銜,1000多名硅谷企業家科學家聯名呼籲

2023-03-29 14:01:22

當全社會都在爲AI的進化而歡呼雀躍,全新的、意想不到的風險可能也正在悄悄酝釀。

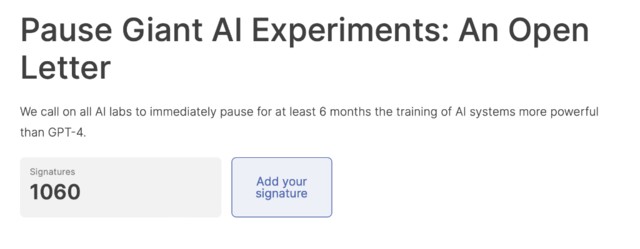

3月22日,生命未來研究所(Future of Life)向全社會發布了一封《暫停大型人工智能研究》的公开信,呼籲所有人工智能實驗室立即暫停比GPT-4更強大的人工智能系統的訓練,暫停時間至少爲6個月。該機構以“引導變革性技術造福生活,遠離極端的大規模風險”爲使命。

該機構在信中提到:

我們不應該冒着失去對文明控制的風險,將決定委托給未經選舉的技術領袖。只有當確保強大的人工智能系統的效果是積極的,其風險是可控的才能繼續开發。 人工智能實驗室和獨立專家應在暫停期間,共同制定和實施一套先進的人工智能設計和开發的共享安全協議,由獨立的外部專家進行嚴格的審查和監督。

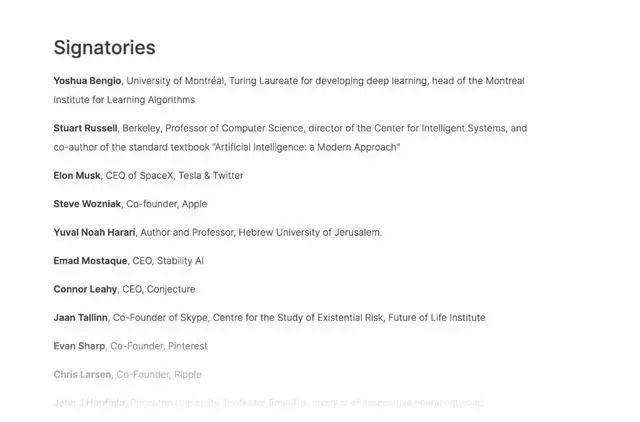

截止目前,馬斯克、蘋果聯合創始人Steve Wozniak、Stability AI 創始人Emad Mostaque等上千名科技大佬和AI專家已經籤署公开信。

值得一提的是,OpenAI CEO奧特曼在與MIT研究科學家Lex Fridman的最新對話中指出,AI已經出現其無法解釋的推理能力,同時承認“AI殺死人類”有一定可能性。

那么ChatGPT是如何看待公开信中AI對人類社會的影響?華爾街見聞專門詢問了ChatGPT 3.5,其表示隨着人工智能技術的不斷發展和普及,人工智能可能對社會和人類造成的影響將越來越大。這封公开信提出的呼籲和建議,應該被視爲引起更廣泛和深入討論的起點和參考,而不是一個終點或解決方案。

以下是公开信原文:

正如廣泛的研究和頂級人工智能實驗室所承認的,人工智能系統對社會和人類構成較大的風險。《阿西洛馬人工智能原則》中指出,高級人工智能可能代表着地球上生命歷史的深刻變革,應該以相應的謹慎和資源進行規劃和管理。然而,盡管最近幾個月人工智能實驗室掀起AI狂潮,开發和部署越來越強大的數字大腦,但目前沒有人能理解、預測或可靠地控制AI系統,也沒有相應水平的規劃和管理。 現在,人工智能在一般任務上變得與人類有競爭力,我們必須問自己:我們應該讓機器在信息渠道中宣傳不真實的信息嗎?我們是否應該把所有的工作都自動化,包括那些有成就感的工作?我們是否應該开發非人類的大腦,使其最終超過人類數量,勝過人類的智慧,淘汰並取代人類?我們是否應該冒着失去對我們文明控制的風險?這樣的決定絕不能委托給未經選舉的技術領袖。只有當我們確信強大的人工智能系統的效果是積極的,其風險是可控的,才應該开發。同時,這種信心必須得到驗證,並隨着系統的潛在影響的大小而加強。OpenAI最近關於人工智能的聲明中指出,在开始訓練未來的系統之前,可能必須得到獨立的審查,對於最先進的努力,同意限制用於創建新模型的計算增長速度。我們同意,現在就該採取行動。 因此,我們呼籲所有人工智能實驗室立即暫停比GPT-4更強大的人工智能系統的訓練,時間至少持續6個月。這種暫停應該是公开的、可核查的,並包括所有關鍵參與者者。如果這種禁令不能迅速實施,政府應該介入並制定暫停令。 人工智能實驗室和獨立專家應在暫停期間,共同制定和實施一套先進的人工智能設計和开發的共享安全協議,由獨立的外部專家進行嚴格的審查和監督。這些協議應該確保遵守協議的系統是安全的。值得一提的是,這並不意味着暫停一般的人工智能开發,只是從危險的競賽中退後一步,限制不可預測的研究和开發。 人工智能的研究和开發應該重新聚焦於,使目前最先進和強大的系統更加準確、安全、可解釋、透明、穩健、一致、值得信賴和忠誠。 同時,人工智能开發者必須與政策制定者合作,大幅加快开發強大的人工智能治理系統。這些至少應該包括:專門針對人工智能的監管機構;監督和跟蹤高能力的人工智能系統和大型計算能力的硬件;出處和水印系統幫助區分真實和合成,並跟蹤模型泄漏;強大的審查和認證生態系統;對人工智能造成的傷害承擔責任;爲人工智能安全技術研究提供強大的公共資金以及資源充足的機構,以應對人工智能可能導致的巨大的經濟和政治破壞。 人類可以通過人工智能享受繁榮的未來。現在,我們成功地創建了強大的人工智能系統,可以在這個“人工智能之夏”中獲得回報,爲所有人的明確利益設計這些系統,並給社會一個適應的機會。停止使用其他技術可能會對社會造成災難性影響,因此我們必須保持準備狀態。讓我們享受一個漫長的人工智能夏天,而不是匆忙進入秋天。

追加內容

本文作者可以追加內容哦 !

0/100